library(tidyverse)

theme_set(theme_bw())

library(faux)

library(lme4)

library(tidyllm)8 Simulation

Wir laden wie immer das Paket tidyverse sowie für die Monte-Carlo-Simulation faux und Auswertung lme4. Für die generativen Agentenmodelle verwenden wir das tidyllm-Paket für die Interaktion mit verschiedenen Large Language Models.

8.1 Studiendaten simulieren

Bei der Planung von Experimenten und anderen empirischen Studien ist es oft hilfreich, künstliche Daten zu genieren, um zu prüfen, ob die Annahmen, das Design und die statistische Auswertung sinnvoll sind. Man unterscheidet dabei in stochastische Ansätze (Monte-Carlo-Simulation) und agentenbasierte Modelle. Wir starten zunächst mit der direkten Simulation von numerischen Daten.

8.1.1 Einfaches Between-Design

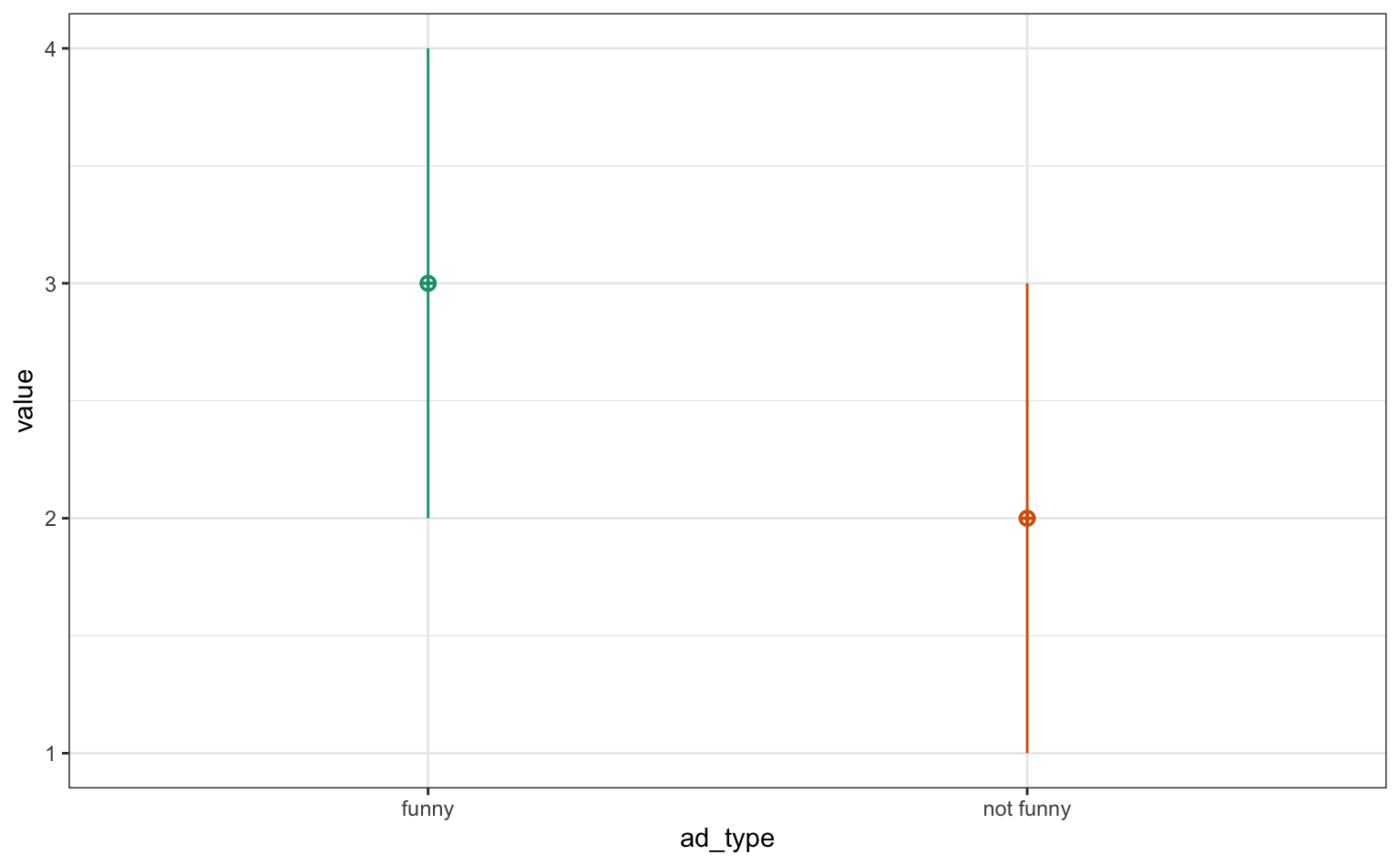

Der folgende Code simuliert Daten für ein einfaches Between-Subjects-Experiment. Die unabhängige Variable ad_type hat zwei Ausprägungen (“funny” und “not funny”). Die Funktion sim_design() aus dem Paket faux generiert die normalverteilte Daten, wobei die Mittelwerte (mu) für die beiden Gruppen unterschiedlich sind (2 bzw. 3), die Standardabweichung 1 ist und die Stichprobengröße pro Gruppe n=50 beträgt. Das Ergebnis wird in einem Tibble (df_between) gespeichert, gleichzeitig wird noch ein Plot erstellt.

between_factor <- list(ad_type = c("funny", "not funny"))

df_between <- sim_design(between = between_factor, mu = c(3, 2), sd = 1, n = 50) |>

as_tibble()

df_between# A tibble: 100 × 3

id ad_type y

<chr> <fct> <dbl>

1 S001 funny 2.46

2 S002 funny 4.21

3 S003 funny 2.71

4 S004 funny 4.75

5 S005 funny 2.98

# ℹ 95 more rowsJede Zeile repräsentiert eine Versuchsperson, und die Spalten enthalten die Ausprägung der unabhängigen Variable (ad_type) und die abhängige Variable (y). Wir vergleichen die simulierten Gruppenmittelwerte und SD, die grob den Input-Daten entsprechen:

df_between |>

group_by(ad_type) |>

summarise(m_y = mean(y), sd_y = sd(y))# A tibble: 2 × 3

ad_type m_y sd_y

<fct> <dbl> <dbl>

1 funny 2.92 1.13

2 not funny 2.19 0.809Nun wollen wir mit einem t-Test prüfen, ob es in den simulierten Daten einen signifikanten Unterschied zwischen den beiden Gruppen der unabhängigen Variable gibt. Die Funktion report_table() aus dem report-Paket formatiert die Ergebnisse des T-Tests in einer übersichtlichen Tabelle.

t.test(y ~ ad_type, data = df_between) |>

report::report_table()Welch Two Sample t-test

Parameter | Group | Mean_Group1 | Mean_Group2 | Difference | 95% CI | t(88.81) | p | d | d CI

---------------------------------------------------------------------------------------------------------------------

y | ad_type | 2.92 | 2.19 | 0.72 | [0.33, 1.11] | 3.68 | < .001 | 0.78 | [0.35, 1.21]

Alternative hypothesis: two.sidedWenig überraschend reproduziert der t-Test unsere simulierten Mittelwertunterschiede in der Grundgesamtheit.

8.1.2 Power-Analyse

Wir können die statistische Power schätzen, in dem wir wiederholt die o.g. Daten simulieren, einen t-Test durchführen und den p-Wert abspeichern. Das geht am besten in einer kleinen Funktion, die nur den p-Wert zurückliefert:

sim_t_test <- function(n) {

sim_data <- sim_design(between = between_factor, mu = c(3, 2), sd = 1, n = n, plot = FALSE)

t.test(y ~ ad_type, data = sim_data)$p.value

}

sim_t_test(n = 10)[1] 0.1938455Wir simulieren die Studie 100 mal und berechnen den Anteil signifikanter Ergebnisse. Dies entspricht der statistischen Power.

p_vals10 <- replicate(100, sim_t_test(n = 10))

mean(p_vals10 <= .05)[1] 0.55Bei 10 Versuchspersonen pro Gruppe haben wir bei erwarteten Mittelwertunterschieden von einer SD ca. 55% Power.

8.1.3 Komplexere Designs

Nun erweitern die Simulation auf komplexere experimentelle Designs mit mehreren unabhängigen Variablen (Between- und Within-Subjects-Faktoren). Der folgende Code simuliert Daten für ein gemischtes Design. Es gibt eine Between-Subjects-Variable (age mit den Ausprägungen “young” und “old”) und zwei Within-Subjects-Variablen (ad_type mit “funny” und “not funny” sowie brand mit “bmw” und “mercedes”). Praktisch entspricht das einem Experiment, in dem jeder Versuchsperson vier Anzeigen gezeigt werden.

Die Funktion sim_design() generiert die Daten im Long-Format (long = TRUE), wobei r die Korrelation zwischen den Messwiederholungen (ICC) und n die Anzahl der Versuchspersonen angibt.

between_factors <- list(age = c("young", "old"))

within_factors <- list(

ad_type = c("funny", "not funny"),

brand = c("bmw", "mercedes")

)

df_mixed <- sim_design(

within = within_factors,

between = between_factors,

mu = 3, sd = 1, r = .5, n = 1000,

long = TRUE, plot = FALSE

) |> as_tibble()Bislang gibt es keine Unterschiede zwischen den Anzeigen (mu ist identisch für alle). Daher erstellen wir jetzt nach unseren theoretischen Überlegungen eine neue Variable y_h1, die einen simulierten Effekt der unabhängigen Variablen enthält. Ältere Personen erhalten einen zusätzlichen Wert von 0.1, und witzige Anzeigen erhalten einen zusätzlichen Effekt von 0.3. Dies simuliert einen Haupteffekt dieser Variablen auf die abhängige Variable.

df_mixed <- df_mixed |>

mutate(y_h1 = (age == "old") * .1 + (ad_type == "funny") * .3 + y)

df_mixed |>

arrange(id)# A tibble: 8,000 × 6

id age ad_type brand y y_h1

<chr> <fct> <fct> <fct> <dbl> <dbl>

1 S0001 young funny bmw 3.11 3.41

2 S0001 young funny mercedes 3.05 3.35

3 S0001 young not funny bmw 4.60 4.60

4 S0001 young not funny mercedes 3.19 3.19

5 S0002 young funny bmw 2.54 2.84

# ℹ 7,995 more rowsMit der Funktion lmer() aus dem lme4-Paket wird ein lineares gemischtes Modell geschätzt, das für dieses Experimentaldesign angemessen ist. Das Modell untersucht den Effekt von ad_type, wobei die Variabilität zwischen den Personen als varying intercept und slope (1 + ad_type | id) berücksichtigt wird.

lmer(y_h1 ~ ad_type + (1 + ad_type | id), data = df_mixed) |>

report::report_table()Parameter | Coefficient | 95% CI | t(7994) | p | Effects | Group | Std. Coef. | Std. Coef. 95% CI | Fit

--------------------------------------------------------------------------------------------------------------------------------------

(Intercept) | 3.35 | [ 3.32, 3.39] | 174.42 | < .001 | fixed | | 0.15 | [ 0.12, 0.19] |

ad type [not funny] | -0.31 | [-0.34, -0.28] | -19.63 | < .001 | fixed | | -0.31 | [-0.34, -0.28] |

| 0.70 | | | | random | id | | |

| 3.15e-03 | | | | random | id | | |

| -0.99 | | | | random | id | | |

| 0.71 | | | | random | Residual | | |

| | | | | | | | |

AIC | | | | | | | | | 20346.74

AICc | | | | | | | | | 20346.75

BIC | | | | | | | | | 20388.66

R2 (conditional) | | | | | | | | | 0.51

R2 (marginal) | | | | | | | | | 0.02

Sigma | | | | | | | | | 0.71Wir finden auch hier den spezifizierten Effekt der Anzeigenart - witzige Anzeigen werden besser bewertet.

8.2 Agentenbasierte Modelle

Alternativ zur statistischen Simulation von Daten können wir auch eine eher subjektbezogene Perspektive einnehmen, d.h. wir spezifizieren sog. Agenten, die sich nach bestimmten Regeln verhalten. Dabei werden zunächst einfache Agenten definiert und später generative Agenten mithilfe von Large Language Models (LLMs) eingesetzt.

8.2.1 Einfache Agenten

Im folgenden Code wird eine einfache Funktion judge_ad() definiert, die simuliert, wie eine Person eine Anzeige bewertet. Die Bewertungsfunktion basiert auf einem Ausgangswert (3), einer zufälligen Komponente (rnorm()) und einem zusätzlichen positiven Effekt (0.3), wenn die Werbung als witzig eingestuft wird. Die nachfolgenden Aufrufe der Funktion zeigen beispielhafte Bewertungen für verschiedene Anzeigentypen.

judge_ad <- function(ad_type) {

3 + rnorm(n = 1) + (ad_type == "funny") * .3

}

judge_ad("funny")[1] 2.97599judge_ad("not_funny")[1] 3.159548Nun erstellen wir eine Population von Agenten mit verschiedenen Eigenschaften, die mit verschiedenen Anzeigen konfrontiert werden. Mit expand_grid() wird ein Dataframe erstellt, der alle möglichen Kombinationen von Alter, Anzeigentyp und Marke enthält. Anschließend wird mit mutate() eine neue Spalte hinzugefügt. Die Funktion map_dbl() wendet unserer eigene Funktion judge_ad() auf jede Zeile der Spalte ad_type an und speichert die resultierenden Bewertungen in der Spalte y.

df_agents <- expand_grid(

age = c("old", "young"),

ad_type = c("funny", "not funny"),

brand = c("BMW", "Mercedes", "VW")

)

df_agents |> mutate(y = map_dbl(ad_type, judge_ad))# A tibble: 12 × 4

age ad_type brand y

<chr> <chr> <chr> <dbl>

1 old funny BMW 2.48

2 old funny Mercedes 2.55

3 old funny VW 3.36

4 old not funny BMW 1.82

5 old not funny Mercedes 3.77

# ℹ 7 more rowsJeder Agent hat nun jede Anzeige bewertet. Die Daten sehen aus wie zuvor, wir können allerdings deutlich komplexere Agenten mit eigenen Bewertungsfunktionen konstruieren.

8.2.2 Generative Agenten

Die Erstellung von Regeln ist bei agentenbasierten Simulationen oft sehr schwierig, weshalb in jüngster Zeit sog. generative Agentenmodelle verwendet werden. Dieser Ansatz nutzt das tidyllm-Paket und ein Large Language Model, um realistischere Agentenantworten zu generieren, die auf rein textbasierten Aufgaben basieren statt auf algorithmischen Simulationen des datengenerierenden Prozesses.

Hier wird eine Aufgabe (task) definiert, die einen generativen Agenten in eine bestimmte Situation versetzt. Die Funktion llm_message() erstellt eine Nachricht für das LLM,und sendet diese Nachricht an das LLM. Der Parameter .temperature steuert die Zufälligkeit der Antwort. .json_schema definiert das erwartete Format der Antwort (ein JSON-Objekt mit numerischen Werten für “ad_liking” und “buy_intention”). Die abschließende Funktion get_reply_data() extrahiert die Antwort des Modells im gewünschten Format.

task <- "Imagine you are looking for a car and checking out ads from different brands.

You see an ad by BMW with the claim 'Honestly now,

did you spend your youth dreaming about someday owning a Nissan or a Mitsubishi?'.

How much do you like the ad - from 1 (not at all) - 5 (very much)?

And how likely are you going to buy the car - from 1 (not at all) - 5 (very likely)?"

llm_message(task) |>

chat(gemini(),

.temperature = .5,

.json_schema = tidyllm_schema(ad_liking = "numeric", buy_intention = "numeric")

) |>

get_reply_data()$ad_liking

[1] 2

$buy_intention

[1] 2Wir erhalten 2 Spalten mit den Antworten des LLM.

Im nächsten Schritt generieren wir Aufgaben für die verschiedenen Agenten aus dem obigen df_agents Datensatz. Zuerst wird basierend auf dem Anzeigentyp ein spezifischer Werbespruch (claim) zugeordnet Anschließend wird mit glue::glue() für jede Kombination von Alter, Marke und Werbespruch eine personalisierte Aufgabe (task) formuliert, die dem LLM gestellt werden soll. Dafür werden Platzhalter im Format {Spalte} zeilenweise ausgefüllt.

df_tasks <- df_agents |>

mutate(claim = ifelse(ad_type == "funny",

"Honestly now, did you spend your youth dreaming about someday owning a Nissan or a Mitsubishi?",

"Refined elegance. Raw power."

)) |>

mutate(task = glue::glue("Imagine you are an interested {age} person looking for a car and checking out ads from different brands.

You see an ad by {brand} with the claim '{claim} - {brand}'.

How much do you like the ad - from 1 (not at all) - 5 (very much)?

And how likely are you going to buy the car - from 1 (unlikely) - 5 (very likely)?"))

df_tasks |>

select(task)# A tibble: 12 × 1

task

<glue>

1 Imagine you are an interested old person looking for a car and checking out a…

2 Imagine you are an interested old person looking for a car and checking out a…

3 Imagine you are an interested old person looking for a car and checking out a…

4 Imagine you are an interested old person looking for a car and checking out a…

5 Imagine you are an interested old person looking for a car and checking out a…

# ℹ 7 more rowsZum Schluss werden die generierten Aufgaben an das LLM gesendet und die Antworten verarbeitet. Der Befehl map() iteriert über jede Aufgabe in der Spalte task und sendet sie an das Gemini-Modell. Die Antworten werden als Listen in der Spalte answers gespeichert. Anschließend wird mit unnest_wider() die Liste in separate Spalten (ad_liking und buy_intention) aufgespalten, und die ursprüngliche Aufgabenspalte wird entfernt.

df_results <- df_tasks |>

mutate(answers = map(task, ~ llm_message(.x) |>

chat(gemini(),

.json_schema = tidyllm_schema(

ad_liking = "numeric",

buy_intention = "numeric"

),

.temperature = .5

) |>

get_reply_data()))

df_results <- df_results |>

unnest_wider(answers) |>

select(-task)

df_results# A tibble: 12 × 6

age ad_type brand claim ad_liking buy_intention

<chr> <chr> <chr> <chr> <dbl> <dbl>

1 old funny BMW Honestly now, did you spend … 4 3

2 old funny Mercedes Honestly now, did you spend … 2 1

3 old funny VW Honestly now, did you spend … 4 3

4 old not funny BMW Refined elegance. Raw power. 3 2

5 old not funny Mercedes Refined elegance. Raw power. 4 3

# ℹ 7 more rowsDer resultierende Dataframe df_results enthält die simulierten Input-Informationen und die generierten Antworten des LLMs.

Abschließend wird wieder ein t-Test durchgeführt, um zu untersuchen, ob es einen signifikanten Unterschied in der Kaufabsicht zwischen den beiden Anzeigentypen gibt, basierend auf den generierten Antworten der LLM-Agenten.

df_results |>

group_by(ad_type) |>

summarise(m_buy = mean(buy_intention))# A tibble: 2 × 2

ad_type m_buy

<chr> <dbl>

1 funny 2.33

2 not funny 2.67t.test(buy_intention ~ ad_type, df_results) |>

report::report_table()Welch Two Sample t-test

Parameter | Group | Mean_Group1 | Mean_Group2 | Difference | 95% CI | t(6.76) | p | d | d CI

--------------------------------------------------------------------------------------------------------------------------

buy_intention | ad_type | 2.33 | 2.67 | -0.33 | [-1.61, 0.95] | -0.62 | 0.555 | -0.48 | [-1.99, 1.07]

Alternative hypothesis: two.sidedInteressanterweise führen in den LLM-basierten Simulationen die witzigen Anzeigen im Schnitt zu geringerer Kaufabsicht, wenn auch nicht statistisch signifikant. Dies ist aber kein empirisches Ergebnis, sondern reproduziert lediglich das Weltwissen und die Biases, die in den Trainingsdaten des Modells vorhanden sind.

Hausaufgabe

- Simulieren Sie Daten für Ihr Experimentaldesign. Wählen Sie plausible Werte aus der Literatur oder schätzen Sie.

- Werten Sie die Daten mit einem passenden Verfahren aus.

- Bonus: Führen Sie eine Power-Analyse mit Hilfe der simulierten Daten durch. Wie viele Versuchspersonen brauchen Sie für ca 80% Power?